在互動展演、沉浸式裝置藝術中「用手就能控制畫面」 一直是最能吸引觀眾、讓人 WOW 的體驗。而如今,不用貴鬆鬆的深度相機,只要一台普通筆電 + TouchDesigner + MediaPipe 就能讓你的手變成魔法控制器!

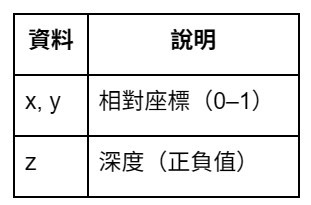

MediaPipe 是 Google 推出的視覺 AI 套件,可偵測 21 個手部關鍵點(包含:手腕、手指關節、指尖等),這些點會輸出

只需要把這些數據轉為互動指令,就能做到:

揮手 → 粒子爆出

捏合 → 縮放模型

指向物件 → 產生光束

V 手勢 → 切換場景

非常適合用來製作互動展演、VR/AR、互動藝術、遊戲

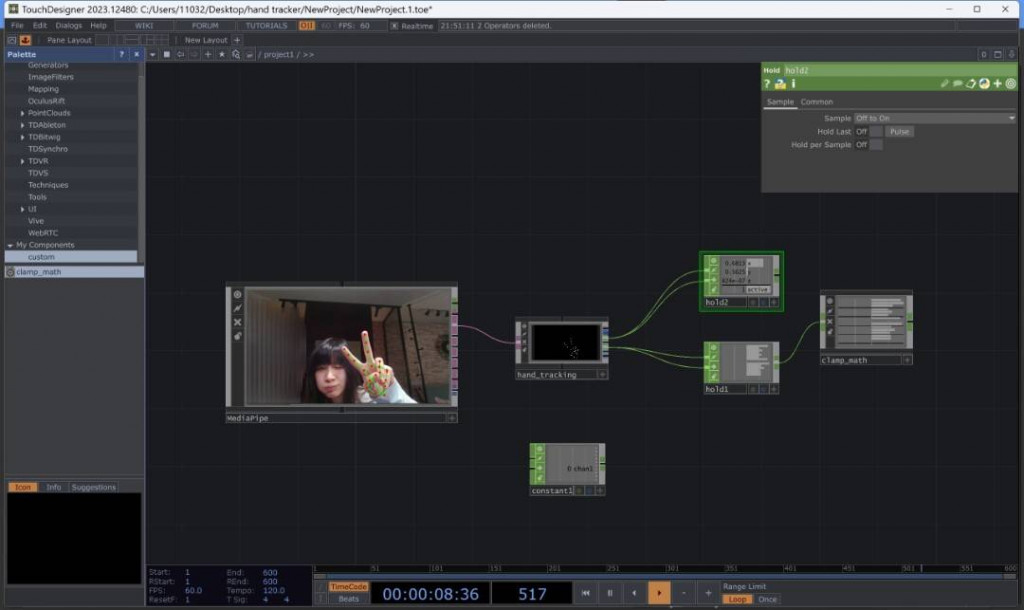

[Webcam]

↓

[MediaPipe TOP → Hand Tracking]

↓ (關節位置座標)

[CHOP data]

↓

[Hold CHOP] → 平滑追蹤

[Clamp Math COMP] → 範圍重新映射(互動控制專用)

↓

粒子 / 物件 / 相機 / 光影控制

核心目的是把手部位置 → 變成可控制視覺效果的數值,只需要你做手勢畫面就跟著動!

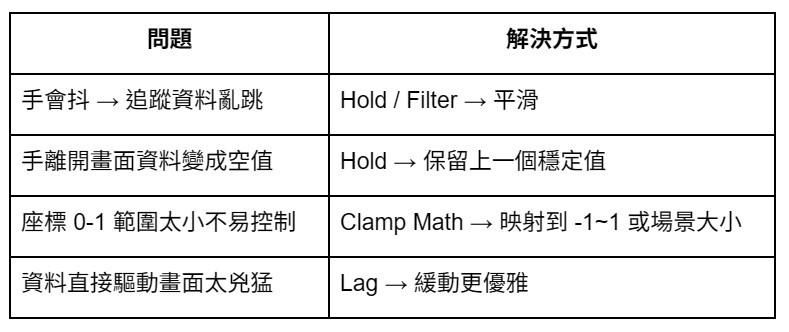

經過這些處理後,手部控制才會跟藝術裝置一樣「順、穩、美」

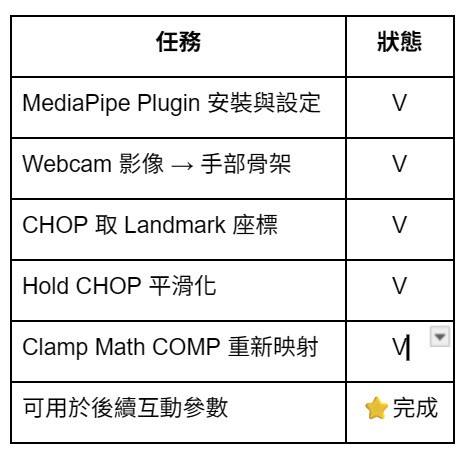

本次課程成果,已能偵測手、已取得手部座標、已完成資料平滑處理、已能控制互動參數,下一步,將這些數據接到:1.粒子發射器 Birth Rate 2.顏色/光暈強度 3.模型或相機位移 4.拖曳物件(3D UI)